|

|

|

|

|

|

LES MATÉRIAUX MOLÉCULAIRES |

|

|

| |

|

| |

LES MATÉRIAUX MOLÉCULAIRES

Réalisation : 27 août 2000 - Mise en ligne : 27 août 2000

* document 1 document 2 document 3

* niveau 1 niveau 2 niveau 3

Descriptif

L' histoire de l'humanité est scandée par la nature des matériaux que l'homme est capable d'élaborer et d'utiliser pour répondre à ses besoins. Notre époque est marquée par une explosion de la création de nouveaux matériaux, de plus en plus conçus pour répondre à un besoin très précis. Dans ce contexte, les matériaux réalisés à partir de molécules peuvent faire valoir de nombreux avantages : ils sont le plus souvent de faible densité, transparents ou colorés à la demande, solubles, biocompatibles, faciles à mettre en forme, etc. La flexibilité de la chimie moléculaire permet de produire pratiquement " à la carte " de nouvelles molécules et de nouveaux édifices moléculaires en variant de manière de plus en plus subtile structures, structures électroniques et propriétés. Les synthèses sont guidées par les besoins en nouveaux matériaux de structure ou en matériaux fonctionnels. Notre vie quotidienne est ainsi entourée de matériaux moléculaires familiers qu'ils soient d'origine naturelle ou industrielle, créations de l'homme. L'exposé les identifie, illustre et commente quelques unes de leurs propriétés et leurs multiples domaines d'application. Dans le même temps, une recherche pluridisciplinaire se poursuit pour obtenir des matériaux présentant des propriétés inédites, voire des propriétés multiples au niveau macroscopique (grands ensembles de molécules) ou au niveau d'une seule molécule (électronique moléculaire, machines moléculaires…). Quelques aspects de ces recherches sont présentés, en mettant en évidence les principes fondamentaux sur lesquels repose la synthèse des molécules et des édifices moléculaires présentant des propriétés données, les techniques récentes qui permettent un progrès plus rapide en matière de matériaux moléculaires, les contraintes qui s'exercent sur la production de ces matériaux et les perspectives qui s'ouvrent dans un domaine où la riche complexité des matériaux biologiques constitue une matière première et un exemple, une source de réflexion et d'espoir permanents.

DOCUMENT canal U LIEN

Documents pédagogiques

Texte de la 240e conférence de l’Université de tous les savoirs donnée le 27 août 2000.Les matériaux moléculaires ou : de la molécule au matériau …par Michel Verdaguer Il est trivial de dire que la notion de matériau a scandé l’histoire de l’humanité : les « âges » qui structurent l’histoire de l’homme portent le nom de matériaux : âge de la pierre, âge du bronze, âge du fer, âge du silicium ou du nylon. Un seul de ces matériaux est un matériau (macro)moléculaire, c’est le nylon, mais c’est le plus récent, le plus complexe, le plus seyant[1]. Qu'est-ce qu'un matériau moléculaire ? Avant toute chose, il est souhaitable de définir ce que l’on entend par matériau moléculaire. Un matériau moléculaire est un matériau constitué de molécules[2]. Une molécule est un ensemble d’atomes reliés entre eux par des liaisons chimiques covalentes. Un matériau est une substance utile qui, convenablement mise en forme, est insérée dans un dispositif pour y remplir une fonction grâce à ses propriétés. C'est souvent un solide. Les matériaux moléculaires sont d'une grande diversité, de la nappe de l’incroyable pique-nique du 14 juillet 2000 (composite de polymères) aux dispositifs d’affichage des écrans de micro-ordinateurs (cristaux liquides). Les matériaux moléculaires parmi les autres matériaux Les grandes classes de matériaux utilisés par l'homme sont les métaux, les céramiques, les polymères[3]. Cette classification, pour une part arbitraire, ne comporte pas de matériau moléculaire au sens strict. Mais les polymères sont des molécules géantes (macromolécules). Chaque type de matériau a des propriétés caractéristiques (mécaniques, physiques, chimiques), correspondant à la structure et au type de liaison concerné : les métaux (liaison métallique) sont des assemblages d'atomes. Ils sont conducteurs, durs, à température de fusion élevée, malléables, ductiles, denses, réfléchissants et opaques. Les céramiques (liaison ionique) sont des assemblages d'ions isolants, réfractaires, denses, résistants mécaniquement et thermiquement mais cassants et fragiles. Les polymères (liaison covalente) sont légers, faciles à mettre en forme, isolants, peu rigides, souvent peu stables à la température. Quand un besoin n'est pas couvert par les grandes classes de matériaux, on fait appel à des composites, mélange complexe de matériaux ou on en crée de nouveaux. Il existe une véritable science des matériaux qui les étudie, les améliore et les crée[4]. Parmi les matériaux nouveaux, figurent précisément les matériaux moléculaires. Contrairement aux céramiques et aux métaux, obtenus à très haute température (donc coûteux en énergie), les matériaux moléculaires et les polymères sont obtenus dans des conditions douces de température et de pression. Ils sont légers, transparents, souvent délicatement colorés, faciles à mettre en forme ; ils sont souvent biocompatibles, biodégradables, recyclables. Dans le cycle des matériaux (Fig. 1), où le souci de l'environnement grandit, ces dernières propriétés sont importantes. Les matériaux moléculaires sont cependant fragiles et peuvent vieillir rapidement (sensibles à l'air, à la lumière …). Les matériaux moléculaires dans l’histoire Un matériau répond le plus souvent à un besoin, individuel ou social. Dans l'histoire, l'apparition de nouveaux matériaux correspond à l'évolution des besoins et à la capacité de l'homme à maîtriser le processus de fabrication du matériau[5] (Fig. 2). La protection contre les éléments est à l'origine de l'utilisation des matériaux moléculaires que sont les fibres naturelles végétales (lin, chanvre, coton à base de cellulose), ou animales (laine, soie à base de polypeptides), les fibres modifiant la matière première naturelle (soie artificielle, nitrate et acétate de cellulose …) ou plus tard les fibres purement synthétiques (nylons)[6]. L'évolution du naturel au synthétique est une constante dans l'histoire des matériaux moléculaires : la nature et les systèmes biologiques sont une source permanente d'exemples, d'inspiration et d'espoir. L'époque contemporaine marque l'accélération vers l'utilisation de matériaux complexes, notamment moléculaires. Le coût des matériaux moléculaires La figure 3 indique le coût des matériaux dans diverses branches industrielles, exprimé en euros par kilogramme. Les matériaux moléculaires interviennent peu dans les industries de la construction. Mais dès que le poids devient un critère de choix (emballage, transport), quand les autres exigences deviennent complexes (équipement sportif, santé …), ils prennent une place importante. Les multiples travaux fondamentaux et appliqués pour leur production industrielle contribuent à l'élévation du coût par unité. Par exemple, les lentilles de contact sont de petits chefs-d'œuvre de transparence, de légèreté, de précision optique et mécanique … Comment créer un matériau moléculaire ? L'élaboration d'un matériau est un long processus qui va de la matière première au produit[7]. Nous n'abordons ici que deux aspects fondamentaux : a) la liaison covalente sur laquelle repose l'existence de molécules stables (dihydrogène, H2 ou fluorure d'hydrogène, HF) et b) les interactions intermoléculaires sur lesquelles repose la construction des solides moléculaires. Nous n'abordons pas les problèmes très importants de mise en forme qui permettent de passer du système moléculaire doté des propriétés requises au matériau. L'existence d'une molécule repose sur l'interaction des atomes qui la constituent. Par combinaison et recouvrement des orbitales atomiques se forment des orbitales moléculaires qui décrivent les électrons dans la molécule[8]. Dans H2, les deux orbitales atomiques forment deux orbitales moléculaires ; les deux électrons se placent dans l'orbitale moléculaire de plus basse énergie (dite liante). L'orbitale la plus haute reste vide (antiliante). La molécule est plus stable que les atomes séparés. Les électrons de la liaison forment un doublet liant. Ils sont également partagés par les deux atomes. La liaison est dite covalente. Pour la casser, il faut fournir une grande quantité d'énergie (environ 450 kiloJoules par mole – ou kJ mol-1 – ; la mole est l'unité de quantité de matière. Au contraire, la molécule HF est formée par deux atomes différents : le fluor et l'hydrogène dont l'énergie des orbitales est différente. La liaison HF est encore plus forte que celle de H2 : 550 kJ mol-1. Mais le doublet de la liaison n'est plus partagé de manière égale entre H et F, il est « attiré » par l'atome de fluor, plus électronégatif ; il apparaît un moment dipolaire électrique dirigé du fluor vers l'hydrogène ; la liaison devient partiellement ionique. Six autres électrons du fluor forment trois doublets non liants. Le dipôle électrique est à l'origine d'interactions intermoléculaires, d'autant plus fortes que le fluor est très électronégatif et que l'hydrogène, petit, peut s'approcher très près du fluor voisin. Ces liaisons hydrogène existent dans l'eau liquide ou solide (glace) où le moment dipolaire électrique O-H est également important. Ces interactions expliquent la structure de la glace et déterminent les températures de changement d'état : pour l'eau, la température d'ébullition Téb est élevée, 100° Celsius, à cause des liaisons hydrogène. Pour le dihydrogène, apolaire, les interactions sont au contraire très faibles (interactions de van der Waals) et la température d'ébullition est très basse (-253° C !). Lorsque l'on place du chlorure de sodium NaCl (sel de cuisine) dans l'eau, le cristal est dissocié et les ions positifs sodium Na+ (cations) et négatifs chlorure Cl- (anions) se « solvatent » i.e. s'entourent de molécules d'eau grâce à des interactions ion-dipôle : ceci est à la base des propriétés de solvant de l'eau et de ses extraordinaires propriétés de transport de matière en biologie et en géologie : l'eau dissout les matières polaires ou ioniques (par interaction hydrophile) et n'interagit pas avec les molécules (ou les parties de molécules) non polaires (par interaction hydrophobe). C'est de la structure et de la nature de la liaison dans les molécules et des interactions entre les molécules que naissent les propriétés, la fonction et l'intérêt du matériau[9]. Molécules et matériaux moléculaires au quotidien Nous utilisons chaque jour des matériaux moléculaires[10] : fibres textiles (vêtements), savons (lessives), cristaux liquides (affichage : montres, ordinateurs, thermomètres) pour ne prendre que trois exemples. Polyamides, polyesters[11] Les fibres textiles artificielles sont des (macro)molécules, formés par l'addition ou la condensation multiple de petites molécules identiques : il se forme de longues chaînes[12]. Les propriétés du matériau reposent sur la structure des molécules de départ, sur les interactions entre les chaînes, puis sur la mise en forme. Ainsi les polyamides sont des polymères obtenus par la création de groupements amide ou peptidique, R-CO-NH-R', tandis que les polyesters comportent des groupements esters, R-CO-O-R'. La liaison hydrogène dans les polyamides renforce les interactions entre les chaînes, donc les propriétés mécaniques des polymères, qui sont excellentes (Fig. 4). Par contre, elle permet l'interaction avec des molécules d'eau : le nylon, qui est un polyamide, retiendra l'eau davantage que les polyesters (qui pourront donc utilisés comme vernis, au contact de l'eau …). D'autres interactions entre les chaînes - par exemple des interactions de van der Waals entre les noyaux aromatiques dans le Kevlar (Fig. 4), améliorent les propriétés mécaniques : le Kevlar est utilisé dans les tissus de protection anti-balles … Le besoin en matériaux complexes conduit à la préparation de composites. Ainsi, la nappe du pique-nique de la méridienne du 14 juillet 2000 assemble astucieusement de nombreux matériaux moléculaires : fibres de cellulose naturelle, liées par pulvérisation avec une émulsion aqueuse d'éthylène-acétate de vinyle ; le support est imperméable en polyéthylène pour la face arrière, contrecollée avec une émulsion aqueuse de styrène-butadiène. L'impression est sérigraphique avec des encres dont le liant est à base de copolymère butadiène. L'épaississant est acrylique. Les encres contiennent des résines acryliques et des pigments minéraux et organiques exempts de métaux lourds[13]. Le revêtement du train à grande vitesse « Méditerranée », conçu par un grand couturier, est également un composite de matériaux moléculaires, intelligemment choisis et artistiquement disposés[14]. Savons dans les lessives[15] Les savons sont obtenus à partir de corps gras, formés à partir de glycérol et d'acides carboxyliques à longues chaînes aliphatiques -(CH2)n-CH3 (Fig. 5A). La stéarine traitée à chaud par une base donne un savon, l'anion stéarate. L'extrémité carboxylate est chargée et hydrophile, l'extrémité aliphatique est hydrophobe. Il s'agit d'une molécule amphiphile ou surfactant. La graisse n'est pas soluble dans l'eau, une tache de graisse sur un tissu ne se dissout dans l'eau pure. On place alors un savon dans l'eau (Figure 5B, Schéma 1) : l'extrémité hydrophobe interagit avec la graisse hydrophobe (2) ; l'extrémité hydrophile est solvatée par l'eau (3). Quand le nombre d'interactions devient suffisant, la graisse est entraînée en tout ou partie (4). Le nettoyage est évidemment favorisé par une température et une agitation adaptées. Les surfactants donnent une nouvelle illustration du remplacement des produits naturels (savons issus de graisses animales ou végétales) par des dérivés de synthèse : les carboxylates ne sont pas très solubles en présence d'ions sodium ou potassium des eaux de lavage « dures » et sont remplacés par des composés plus solubles comme le benzenesulfonate à chaîne branchée, obtenu à partir d'un sous-produit de l'industrie pétrolière le méthylpropène, de benzène et d'acide sulfurique. C'est l'un des « détergents anioniques » des lessives. Les savons illustrent aussi le souci de l'environnement : les chaînes branchées ne sont pas biodégradables et encombrent les eaux, d'où l'apparition sur le marché d'autres détergents « non ioniques », non branchés, tout aussi solubles grâce à des groupements fonctionnels alcool et éther (Fig. 5C). Cristaux liquides[16] Les cristaux liquides sont des matériaux moléculaires qui représentent un nouvel état de la matière, l'état mésomorphe, dont l'organisation est intermédiaire entre l'ordre tridimensionnel du cristal et le désordre relatif du liquide (Fig. 6A). Ils ne présentent pas de température de changement d'état liquide-solide mais des températures correspondant à des organisations intermoléculaires variées : nématiques, smectiques, … (Fig. 6B). Ces propriétés exceptionnelles reposent sur l'auto-organisation d'assemblées de molécules anisotropes, i.e. qui n'ont pas les mêmes propriétés dans les trois directions de l'espace (molécules allongées). La direction dans laquelle les molécules s'orientent en moyenne est appelée directrice. Les interactions entre les molécules qui conduisent à l'état mésomorphe sont faibles de type Van der Waals[17]. Lorsque l'on applique un champ électrique, les molécules s'orientent de manière à minimiser l'énergie du système. Si on place un cristal liquide entre deux plaques, l'une qui polarise la lumière, l'autre qui l'analyse, on peut disposer les polariseurs de manière à ce qu'aucune lumière ne passe (Fig. 6C). L'application d'un champ électrique oriente différemment les molécules et permet le passage de la lumière : le dispositif passe du noir à l'incolore (ou inversement), c'est le principe de l'affichage sur un écran. Des dispositifs électroniques de plus en plus élaborés (nématique « supertordu » et écrans « à matrice active » (où un transistor est associé à chaque domaine de cristal liquide) sont disponibles pour accélérer la vitesse d'affichage. Certains autres cristaux liquides (cholestériques chiraux) sont organisés de telle manière que la directrice tourne régulièrement autour d'un axe perpendiculaire à celle-ci. La directrice reprend la même orientation avec un pas p, dont dépend la réflexion de la lumière par le composé. Quand la température change, p varie (par contraction ou dilatation thermique) et le cristal liquide change de couleur : les thermomètres fondés sur ce principe sont très répandus. Élaboration de nouveaux matériaux fonctionnels L'un des problèmes importants posés aux laboratoires universitaires et industriels est la mise au point de nouveaux matériaux fonctionnels. Le concept de fonction est ici utilisé par opposition à celui de structure : le béton assure des propriétés structurales, le polymère des lentilles jetables assure de multiples fonctions : correction de la vue, transparence, perméabilité au dioxygène, hydrophilie). Les exemples ci-dessous montrent que la structure moléculaire contrôle les propriétés. Propriétés optiques La couleur des composés moléculaires est déterminée par la manière dont ils interagissent avec la lumière : ils peuvent la transmettre, la diffuser, la réfléchir de manière plus ou moins complexe en fonction de la structure moléculaire et de la microstructure du matériau[18]. Une lumière monochromatique de longueur d'onde l est constituée de photons d'énergie hn (h est la constante de Planck et n la fréquence de la lumière). La lumière visible correspond à des longueurs d'onde l comprises entre 400 et 800 nanomètres (nm). L'absorption de la lumière correspond à l'excitation d'un électron d'une orbitale moléculaire occupée vers une orbitale vacante. Seuls les photons dont l'énergie correspond exactement à la différence d'énergie entre les niveaux occupés et vacants sont absorbés. Par transmission, l'œil voit les longueurs d'onde non absorbées : si un matériau absorbe dans le rouge (600-800nm), il apparaît bleu par transmission. La structure des molécules peut être modifiée pour moduler les énergies des orbitales et donc la couleur. La garance, extraite de la racine de Rubia tinctorum, contient de l'alizarine qui peut être produite industriellement (Fig. 7). C'est la compréhension de la structure moléculaire des colorants (alizarine, indigo) qui a permis à l'industrie chimique allemande, à la fin du 19ème siècle d'asseoir sa suprématie dans ce domaine, en ruinant l'industrie d'extraction des colorants naturels[19]. Au-delà de la couleur, l'interaction de la lumière avec les matériaux a de multiples applications : l'absence d'absorption conduit à des matériaux transparents (polymères des lentilles oculaires[20] …) ; les crèmes de protection solaires ou les lunettes de soleil (verres photochromes[21]) protègent des rayons ultraviolets avec des molécules organiques conçues pour arrêter tout ou partie des rayons (écrans A, B …), comme l'ozone le fait dans la haute atmosphère. D'autres matériaux, asymétriques, traversés par une lumière de fréquence donnée, créent une lumière de fréquence double ou triple (matériaux pour l'optique non linéaire). D'autres systèmes émettent de la lumière par désexcitation d'une molécule excitée : ver luisant, diode luminescente, bâton lumineux chimiluminescent à base de luminol …). Le linge « plus blanc que blanc » existe bel et bien : il n'absorbe pas la lumière, il la diffuse et il en émet grâce à des additifs luminescents peroxygénés déposés sur les tissus par la lessive[22] ! Propriétés électriques La conductivité mesure la capacité d'un corps à conduire le courant. C''est l'une des grandeurs physiques qui varie le plus : plus de 20 ordres de grandeur entre les matériaux les plus isolants et les plus conducteurs. Les supraconducteurs ont même une conductivité qui tend vers l'infini. Les matériaux conducteurs métalliques sont généralement des métaux ou des oxydes. Les matériaux moléculaires sont pour la plupart isolants (s très faible), mais les chimistes ont réussi à transformer certains d'entre eux en conducteurs métalliques. L'idée est simple : en plaçant côte à côte un nombre infini d'atomes, on construit une bande d'énergie de largeur finie, formée d'une infinité de niveaux (ou d'orbitales) (Fig. 8, schémas 1-5). Quand la bande est vide et séparée en énergie des autres bandes (1), il y a ni électron, ni conduction. Quand la bande est pleine, chaque O.M. contient deux électrons qui ne peuvent se déplacer (isolant). Pour qu'il y ait conductivité, certains niveaux de la bande doivent être inoccupés (vacants ou partiellement vacants -3,4). Un semi-conducteur correspond au cas 5. La bande peut être construite par des orbitales atomiques du carbone dans un polymère comme le polyacétylène ou par l'empilement de molécules [tétrathiafulvalène (TTF) ou tétracyanoquinodiméthane (TCNQ)]. Le polyacétylène est isolant. Quand on l'oxyde, on enlève des électrons dans une bande qui devient partiellement occupée et le matériau devient conducteur. Il s'agit d'une discipline très active qui a valu le prix Nobel 2000 à trois chercheurs américains et japonais (A.J. Heeger, A.G. MacDiarmid, H. Shirakawa)[23]. Propriétés magnétiques[24] Ici encore les matériaux magnétiques traditionnels sont des métaux ou des oxydes (aimants domestiques, moteurs …). Les chimistes savent aujourd'hui construire des matériaux magnétiques moléculaires, à partir de complexes d'éléments de transition ou de radicaux organiques stables. À chaque électron est associé un spin S = 1/2 et un moment magnétique élémentaire. Les éléments de transition présentent 5 orbitales d où peuvent se placer 10 électrons. L'environnement chimique du métal constitué de molécules appelées ligands, permet de contrôler l'énergie des orbitales et la manière de les remplir avec des électrons : dans un complexe octaédrique ML6, par exemple, l'élément de transition est entouré de six molécules. La symétrie permet de prévoir que les cinq orbitales d dans le complexe sont séparées en deux familles : trois orbitales appelées t2g, deux orbitales appelées eg, séparées par une énergie ∆oct, variable avec les ligands. La théorie qui décrit le phénomène porte le joli nom de « champ cristallin » ou « champ des ligands ». Les électrons ont alors le choix : occuper le maximum d'orbitales (ce qui, pour les orbitales eg, coûte l'énergie ∆, ou se mettre en paire dans une même orbitale (ce qui coûte une énergie d'appariement P). Prenons l'exemple de 5 électrons (Fig. 9) : a) quand ∆ < P, le champ est faible et le spin est fort (S = somme des cinq spins parallèles = 5/2) ; b) quand ∆ > P, les électrons se regroupent par paires dans les orbitales t2g ; le champ est fort et le spin est faible (S = 1/2). Dans la situation intermédiaire où ∆ est à peu près égal à P, le complexe peut être de spin fort ou faible, en fonction des contraintes appliquées (température kT, pression, lumière). C'est le phénomène de transition de spin qui se manifeste par un changement de propriétés magnétiques et de couleur (car ∆ change lors de la transition). Quand la transition se manifeste à température ambiante et présente le phénomène dit d'hystérésis (la température de transition « spin fort-spin faible » (blanc-rouge, par exemple) est différente de celle de la transition inverse, spin faible-spin fort. Il existe un domaine de température où le système peut être spin fort (blanc, quand il vient des hautes températures), ou spin faible (rouge quand il vient des basses températures). C'est un système bistable, « à mémoire » en quelque sorte, qui « se souvient » de son histoire (thermique), utilisable pour l'affichage[25]. Au-delà de cet exemple, l'application de règles simples permet de construire des matériaux magnétiques. Quand deux électrons occupent deux orbitales sur deux atomes voisins A et B, trois situations existent : a) quand les orbitales se recouvrent, comme dans le cas de la molécule de dihydrogène, on obtient un couplage antiferromagnétique entre les spins (les spins sont d'orientation opposée, antiparallèle, le spin total ST = SA - SB = 0) ; b) quand les orbitales ne se recouvrent pas (elles sont orthogonales), les spins s'orientent parallèlement et le couplage est ferromagnétique S = SA + SB = 1) ; c) une situation amusante naît quand les orbitales se recouvrent et que le nombre d'électrons est différent sur A et B, alors ST = SA - SB ≠ 0, le spin résultant est non nul. Paradoxalement et dialectiquement, l'antiferromagnétisme engendre son contraire, un magnétisme résultant. Cette idée a valu le prix Nobel à Louis Néel. En étendant de proche en proche l'interaction dans les trois directions de l'espace, jusqu'à l'infini, à une certaine température critique, TCurie, un ordre magnétique à longue distance apparaît où tous les grands spins sont alignés dans un sens et tous les petits spins sont alignés en sens inverse. C'est ainsi qu'en utilisant la stratégie des orbitales orthogonales [ i.e. avec du chromicyanure de potassium (3 orbitales t2g) combiné avec du nickel(II) (2 orbitales eg)], Véronique Gadet, à obtenu un aimant ferromagnétique avec une température de Curie, 90 Kelvins (K), supérieure à la température de liquéfaction de l'azote liquide, 77K[26]. En utilisant la stratégie du ferrimagnétisme, Sylvie Ferlay a obtenu un aimant qui s'ordonne un peu au-dessus de la température ambiante (42°C ou 315K)[27]. Deux points méritent d'être soulignés dans ce résultat : le caractère rationnel de l'approche et la possibilité qu'il offre désormais de passer aux applications pratiques des aimants à précurseurs moléculaires. Un exemple est donné sur la figure 10. L'aimant à précurseur moléculaire est dans une ampoule dans un gaz inerte (argon) car exposé à l'air, il perd ses propriétés. Il est suspendu à un point fixe, comme un pendule. Quand il est froid, il est attiré par un aimant permanent (1). En ce point, il est chauffé par un faisceau lumineux (lampe, soleil). Quand sa température dépasse la température d'ordre, il n'est plus attiré par l'aimant et repart vers la verticale (2). Hors du faisceau, l'air ambiant le refroidit (3) et il est à nouveau attiré : d'où un mouvement oscillant où l'énergie lumineuse se transforme en énergie mécanique, en utilisant deux sources gratuites d'énergie : l'énergie solaire et l'air ambiant. Des millions de cycles ont ainsi été effectués sans fatigue du système. La recherche de nouveaux matériaux magnétiques moléculaires est très active, au niveau national et international. Certains matériaux sont capables de présenter plusieurs fonctions (magnétisme modulé par la lumière pour l'enregistrement photomagnétique)[28], aimants optiquement actifs (qui font tourner à volonté la lumière polarisée soit à droite soit à gauche)[29] … Matériaux pour l’électronique moléculaire[30] L'un des développements le plus excitant est celui des matériaux pour l’électronique moléculaire. Sous ce terme se cachent diverses interprétations : matériaux moléculaires pour l'électronique (dont les cristaux liquides ou les polymères sont des exemples) ou l'électronique à l'échelle de la molécule. Tous les exemples que nous avons cités jusqu'à présent faisaient intervenir des ensembles macroscopiques de molécules, i.e. des moles de molécules. La recherche se développe pour concevoir et réaliser des molécules se prêtant à des expériences d'électronique sur une seule entité moléculaire avec notamment des techniques de microscopie à champ proche (où la molécule joue le rôle de conducteur, de diode, de photodiode …). Par exemple le mouvement de miniaturisation de l'électronique (électronique portable, enregistrement de quantités de plus en plus grande d'information sur des surfaces de plus en plus petites, calcul quantique …) peut aboutir à la mise au point de dispositifs permettant de stocker l'information à l'échelle ultime, celle d'une seule molécule[31]… Le présent se conjugue déjà au futur. Conclusion Dans un monde qui va vers plus de complexité, le développement des matériaux moléculaires n'en est qu'à son début. Les possibilités offertes par la flexibilité de la chimie moléculaire et supramoléculaire qui ont ouvert ce cycle de leçons[32], la chimie des métaux de transition et la chimie du carbone, sont pour l'essentiel inexplorées mais immenses[33]. La compréhension fondamentale et pluridisciplinaire des propriétés de la matière, la capacité du chimiste à maîtriser la synthèse pour obtenir les propriétés souhaitées peuvent permettre de répondre de mieux en mieux aux nouveaux besoins de l'homme et de la société. À eux d'en faire bon usage. Remerciements Ce travail sur les matériaux moléculaires a été alimenté par de nombreuses discussions dans mon équipe, dans mon laboratoire et dans les nombreux établissements que j'ai fréquentés et financé par le Ministère de l'Education Nationale, le C.N.R.S., les contrats européens M3D et Molnanomag, l'ESF (Molecular Magnets). Les expériences ont été préparées par F. Villain. Les matériaux présentés ont été aimablement prêtés par de nombreux fournisseurs auxquels je suis reconnaissant. Je dédie cette contribution à la mémoire de deux scientifiques français dont j'ai beaucoup appris, Olivier Kahn décédé en décembre 1999 et Louis Néel, prix Nobel de Physique 1970, dont j'apprends la disparition.

[1] Elsa Triolet, L’âge de nylon, Œuvres romanesques croisées d'Elsa Triolet et d'Aragon, Robert Laffont, Paris, 1959. [2] Jacques Simon, Patrick Bernier, Michel Armand, Jacques Prost, Patrick Hémery, Olivier Kahn, Denis Jérôme, Les matériaux moléculaires, p. 401-404, La Science au présent, Tome II, Encyclopædia Universalis, 1992. P. Bassoul, J. Simon, Molecular materials, Wiley, New York, 2000. [3] J.P. Mercier, G. Zambelli, W. Kurz, Introduction à la science des matériaux, Presses polytechniques romandes, Lausanne, 1999. [4] R.E. Hummel, Understanding Materials Science, Springer, Berlin, 1998. [5] André Leroi-Gourhan, L'homme et la matière, Albin Michel, Paris, 1971. B. Bensaude-Vincent, I. Stengers, Histoire de la chimie, La découverte, Paris, 1993. [6] Encyclopædia Universalis, Paris, 1990, article Textiles (Fibres). Pour la Science, N° spécial, Fibres textiles et tissus biologiques, Décembre 1999. [7] Encyclopædia Universalis, Paris, 1990, article Matériaux. [8] Encyclopædia Universalis, Paris, 1990, articles Liaisons chimiques et Molécule. J.P.Malrieu, ce volume. L. Salem, Molécule, la merveilleuse, Interéditions, Paris, 1979. Y. Jean, F. Volatron, Atomistique et liaison chimique, Ediscience, Paris, 1995. T. A. Nguyen, Introduction à la chimie moléculaire, École Polytechnique, Ellipses, 1994. [9] P.W. Atkins, Molecules, Freeman, New York, 1987 et traduction française. [10] Ben Selinger, Chemistry in the Market Place, Harcourt Brace, Sidney, 1998. [11] Jean Bost, Matières plastiques (Tomes I et II), Technique et Documentation, Paris, 1985. Groupement Français des Polymères, Les polymères, Paris. [12] Encyclopædia Universalis, Paris, 1990, articles Macromolécules, Polymères et Textiles (Fibres). [13] Communication de la société Fort Williams (Lotus), Gien. [14] Communication du service commercial de la SNCF, Paris. [15] Encyclopædia Universalis, Paris, 1990, article Corps gras. Ben Selinger, Chemistry in the Market Place, Harcourt Brace, Sidney, 1998. [16] Encyclopædia Universalis, Paris, 1990, article Cristaux liquides et Mésomorphe (État). [17] Encyclopædia Universalis, Paris, 1990, article Van der Waals. [18] Encyclopædia Universalis, Paris, 1990, article Couleur. [19] Pour la Science, Dossier « La couleur », Avril 2000, notamment G. Bram, N. T. Anh, L'avènement des colorants synthétiques p. 52. [20] Communications de la société Ciba, Paris. [21] Communications de la Société Essilor, Paris. [22] Ben Selinger, Chemistry in the Market Place, Harcourt Brace, Sidney, 1998. [23] L'actualité Chimique, Société Française de Chimie, Novembre 2000, p. 64. [24] O. Kahn, Molecular Magnetism, VCH, New York, 1993. M. Verdaguer et al., Images de la Physique, CNRS, Paris, 2000. [25] O. Kahn, Magnétisme moléculaire, La Recherche, Paris, 1994. [26] V. Gadet et al., J. Am. Chem. Soc. 1992, 114, 9213-9214. [27] S. Ferlay et al. Nature, 378, 701, 1995. [28] M. Verdaguer, Science, 272, 698, 1996. A. Bleuzen, J. Am. Chem. Soc., 2000, 122, 6648. C. Cartier ibid. 6653. d) H. Hashimoto et al. ibid 704. [29] M. Gruselle, C. Train travail en cours. [30] M.C. Petty, M.R. Bryce, D. Bloor, Molecular Electronics, Edward Arnold, Londres, 1995. J. Jortner, M. Ratner, Molecular Electronics, I.U.P.A.C., Blackwell Science, 1997. [31] D. Gatteschi, R. Sessoli et al. Nature 1993, 365, 141. V. Marvaud, travail en cours. [32] J.M. Lehn, Chimie supramoléculaire, VCH, New York, 1997. T.A. Nguyen, J.M. Lehn, ce volume. [33] Dossier : 1999, Année internationale de la chimie, Pour la Science, Décembre 1999, p. 69-84 : J.M. Lehn, J.P. Launay, T. Ebbesen, G. Ourisson … La Science au présent, Encyclopædia Universalis, 1998 ; a) M.W. Hosseini, b) J.P. Sauvage, ; c) P. Bernier.

|

| |

|

| |

|

|

|

oxydoréduction |

|

|

| |

|

| |

oxydoréduction

Consulter aussi dans le dictionnaire : oxydoréduction

Cet article fait partie du dossier consacré à la réaction chimique.

Action chimique d'un corps oxydant sur un corps réducteur, avec à la fois une oxydation du réducteur et une réduction de l'oxydant.

LE PHÉNOMÈNE D’OXYDORÉDUCTION

L'importance de l'oxydoréduction, phénomène chimique ou électrochimique, est considérable tant par ses effets spontanés, bénéfiques (photosynthèse) ou néfastes (corrosion), que par ses applications multiples dans la vie quotidienne (piles, accumulateurs…) ou dans l'industrie chimique et électrochimique.

Depuis la découverte du feu, l'homme a su mettre à profit la combustion du bois pour obtenir de l'énergie thermique ainsi que la réduction des minerais lors de la préparation du fer, sans connaître les réactions chimiques mises en jeu. Ce n'est qu'à la fin du xviiie s. que la combustion est apparue comme une oxydation, c'est-à-dire une combinaison avec un élément de l'air, l'oxygène.

Au sens strict, l'oxydation est la fixation d'oxygène sur un corps, la réduction, le phénomène inverse ; ces deux phénomènes sont d'ailleurs généralement couplés. Ainsi, dans la réaction 2CuO + C → 2Cu + CO2, on assiste simultanément à l'oxydation du carbone et à la réduction de l'oxyde de cuivre ; ce dernier est l'oxydant (noté Ox), le carbone étant le réducteur (Red) ; la réaction est une oxydoréduction.

Plusieurs éléments, tels les halogènes, le soufre, etc., se comportent dans certaines de leurs réactions comme l'oxygène ; on convient de dire que, par exemple, la combustion du sodium dans le chlore (qui donne Na+Cl−) est une oxydation du métal, au même titre que sa combustion dans l'oxygène. La transformation du sodium en ions Na+ est une oxydation du sodium ; elle est obtenue par enlèvement d'électrons. Corrélativement, la réduction du chlore en ions chlorure Cl− résulte de la fixation d'électrons. Au cœur de l'oxydoréduction se trouve donc l'électron, particule très mobile et omniprésente dans toutes les formes de la matière.

LE COUPLE REDOX

Le sens du terme oxydoréduction, contraction de « oxydation » et de « réduction », a évolué au cours du temps : ainsi pour Antoine Laurent de Lavoisier, le terme oxydation signifiait fixation d'oxygène, et le mot réduction désignait la perte d'oxygène, par exemple :

S + O2 → SO2 (oxydation),

2HgO → 2Hg + O2 (réduction).

Cependant, on constate que dans de nombreux cas l'expression ne porte que sur l'évolution chimique d'un seul des deux constituants de la réaction ; ainsi en est-il de la réduction de l'oxyde de cuivre II par le dihydrogène :

CuO + H2 → Cu + H2O,

où une ambiguïté apparaît, dans les termes, car on néglige ici le dihydrogène qui, lui, subit une oxydation. En fait, et d'une manière générale, toute réaction de réduction est accompagnée d'une réaction d'oxydation, et réciproquement. Seule l'électrochimie permet de les séparer dans certaines conditions.

Mais il apparaît que la notion d'oxydation peut s'appliquer aussi à la réaction :

Li + 1/2 Cl2 → LiCl,

comparable à la réaction :

2Li + 1/2 O2 → Li2O ;

dans la première, le lithium (Li) est transformé en Li+ par la perte d'un électron (e−), récupéré par le dichlore ; dans la seconde, deux électrons perdus par deux atomes Li sont fixés par l'oxygène pour former l'ion O2− ; dans les deux cas, on dit qu'il s'agit d'une oxydation du lithium due à une perte d'électrons, accompagnée d'une réduction du chlore ou de l'oxygène due, elle, à un gain d'électrons.

Une autre façon d'exprimer le phénomène est de dire que le lithium est un réducteur, c'est-à-dire une espèce chimique pouvant fournir un électron, et que le dichlore et le dioxygène sont des oxydants susceptibles de capter un ou des électrons. Li et Li+ forment ce qu'on appelle un couple redox (abréviation de réduction-oxydation), noté Li+/Li (soit Ox/Red).

On l'écrit : Li ⇌ Li+ + e−,

Li étant le réducteur, et Li+ l'oxydant. La double flèche indique que, dans certaines conditions, on sait réaliser :

Li+ + e− → Li (ce qui est du domaine de l'électrochimie).

D'une manière générale, on peut écrire les demi-réactions d’oxydoréduction suivantes :

Red1 ⇌ Ox1 + n1e−

et :

Ox2 + n2e− ⇌ Red2.

LES RÉACTIONS D'OXYDORÉDUCTION

Les équations chimiques correspondant aux réactions d'oxydoréduction peuvent être décrites en utilisant les couples redox, sous réserve de satisfaire à certaines conditions thermodynamiques, et de telle sorte que les électrons fournis par le réducteur 1 (Red1) soient récupérés par l'oxydant 2 (Ox2). Ainsi, l'équation chimique générale d'oxydoréduction :

n2Red1 + n1Ox2 ⇌ n2Ox1 + n1Red2

fait-elle intervenir les deux couples redox suivants :

(Red1 ⇌ Ox1 + n1e−) . n2

et

(Ox2 + n2e− ⇌ Red2) . n1,

dont l'addition permet de retrouver l'équation précédente. Cette façon de procéder est aisée quand interviennent des réactions ioniques qui permettent de connaître n1 et n2 sans difficulté. Par exemple, l'action d'un acide en milieu aqueux sur le zinc fait intervenir deux couples redox bien connus :

Zn → Zn2+ + 2e−,

(H3O+ + e− → 1/2 H2 + H2O) . 2.

Dans les conditions thermodynamiques convenables, les deux réactions se produisent dans le sens 1, donnant la réaction globale :

Zn + 2 H3O+ → Zn2+ + H2 + 2 H2O.

LE DEGRÉ D'OXYDATION

Il existe aussi des couples redox tels que :

Fe2+ ⇌ Fe3+ + e−, où l'on voit aisément que Fe3+ est plus oxydé que Fe2+, puisqu'il résulte de la perte d'un électron par ce dernier.

Mais, avec des ions comme Cl−, ClO−,ClO3−, ClO4−, il est difficile de distinguer les éléments les plus oxydés.

Les chimistes ont été ainsi amenés à attribuer un degré d'oxydation, ou nombre d'oxydation (NO), positif ou négatif, aux différents éléments et à leurs ions lorsqu'ils sont engagés dans divers composés ; pour le distinguer de la charge des ions, on le représente par un chiffre romain, précédé du signe + ou −. Pour déterminer ce nombre formel, on utilise les règles suivantes :

– tout élément à l'état de corps pur a un nombre d'oxydation 0 (c'est le cas de O dans O2, de H dans H2, de Fe dans le fer métal) ;

– dans une espèce chimique non chargée, la somme algébrique des NO des éléments constitutifs est égale à 0 (c'est le cas pour H et O dans H2O, pour Na et Cl dans NaCl);

– dans une espèce ionique, la somme algébrique des NO des éléments constitutifs est égale à la charge de l'ion. Ainsi, dans ClO−, la somme algébrique des NO de Cl et de O est −1 ; il en est de même dans ClO4−.

Partant de ces règles, le NO d'un élément dans une molécule ou dans un ion est, en valeur absolue, égal au nombre d'électrons qu'il aurait fixés, si c'est l'élément le plus électronégatif, ou qu'il aurait perdus, si c'est l'élément le moins électronégatif, si on considérait que toutes ses liaisons sont ioniques. On lui attribue le signe − s'il a fixé les électrons, le signe + s'il les a perdus. Plus le nombre d'oxydation est élevé (en valeur algébrique), plus l'élément est oxydé ; plus il est bas, plus l'élément est réduit. Par exemple :

H+, Li+, Na+, … NO = + I ;

Al3+, Te3+, Cr3+, … NO = + III ;

H−, F−, Cl−, … NO = − I ;

O2−, S2−, … NO = − II.

Dans le cas des ions simples, le NO est donc égal à la charge de l'ion.

L'ÉQUATION DE NERNST

Si le système redox :

Ox + ne− ⇌ Red,

obéit aux lois de la thermodynamique (les phénomènes cinétiques, très importants dans ce domaine, risquent de masquer le comportement thermodynamique), une expression relativement simple, l'équation de Nernst, lie le potentiel ET de ce système (où la concentration de l'oxydant et celle du réducteur ne sont pas égales à 1 mol . −1) au potentiel standard E0t (où la concentration de l'oxydant et celle du réducteur sont égales à 1 mol . l−1) et au nombre n d'électrons échangés à une température donnée T :

Et = E0t + (RT/nΦ) × log [Ox]/[Red],

où E0t, potentiel standard du système (sous une pression de 1 bar), est une constante, consignée dans des tables, qui en caractérise la nature chimique à une température donnée T exprimée en degrés Kelvin (si T = 298 K, E0 est le potentiel standard normal),

R la constante des gaz parfaits (8,31 J . K−1 . mol−1),

Φ la constante de Faraday (96 500 C . mol−1),

[Ox] et [Red] correspondant aux activités de Ox et de Red que l'on assimile ici aux concentrations [Ox] et [Red] en mol . l−1.

À 298 K (25 °C), cette expression s'écrit souvent sous la forme :

Et = E0t + (0,06/n) × log [Ox]/[Red],

où les potentiels sont exprimés en volts (V).

PRÉVISION DES RÉACTIONS

En solution, lorsque l’on a en présence deux couples rédox Ox1/Red1 et Ox2/Red2, de potentiels standards respectifs E01 et E02, et que E01 > E02, c'est l'oxydant 1, appartenant au couple redox 1 – dont le potentiel est le plus élevé – qui oxyde le réducteur 2 appartenant au couple redox 2 – dont le potentiel est le moins élevé.

APPLICATIONS

Les réactions d'oxydoréduction interviennent dans nombre de processus naturels ou artificiels, tant dans des réactions en solution qu'en phase solide. Tel est le cas de la plupart des réactions métallurgiques permettant l'élaboration des métaux à partir de leurs minerais, comme celle citée en introduction. Ces réactions, dont certaines étaient connues depuis l'Antiquité, mettaient déjà en pratique des principes thermodynamiques qui ne furent élucidés que bien plus tard. Cela explique que, au cours de l'histoire, les métaux ont été élaborés dans l'ordre de difficulté croissante de réduction, depuis le cuivre, vers 4000 avant J.-C., jusqu'à l'aluminium, en 1825. Les phénomènes d'oxydoréduction ont également un rôle crucial en biologie. Ils permettent notamment la respiration cellulaire des organismes vivants.

PLAN

* LE PHÉNOMÈNE D’OXYDORÉDUCTION

* LE COUPLE REDOX

* LES RÉACTIONS D'OXYDORÉDUCTION

* LE DEGRÉ D'OXYDATION

* L'ÉQUATION DE NERNST

* PRÉVISION DES RÉACTIONS

* APPLICATIONS

DOCUMENT larousse.fr LIEN |

| |

|

| |

|

|

|

réaction chimique |

|

|

| |

|

| |

réaction chimique

Consulter aussi dans le dictionnaire : réaction

Cet article fait partie du dossier consacré à la réaction chimique.

Transformation se produisant lorsque plusieurs espèces chimiques sont mises en présence, ou lorsqu'une seule espèce chimique reçoit un apport extérieur d'énergie, et se traduisant par l'apparition d'espèces chimiques nouvelles.

CHIMIE

Opération fondamentale par laquelle on crée de nouvelles substances, la réaction chimique consiste en une transformation de la matière. Au cours de celle-ci, les atomes des molécules des réactifs se séparent puis se réarrangent pour donner naissance à de nouvelles molécules, qui constituent les produits de la réaction. Avant de tenter une réaction, il faut se demander si les réactifs mis en présence vont réagir pour donner les produits espérés. La plupart des réactions chimiques se déroulent en effet dans un sens privilégié. Dans certains cas, c'est l'inverse de la réaction souhaitée qui tend à se produire ! La solution de ce problème nécessite le recours à la thermodynamique chimique.

Lorsqu'une réaction est « possible » – elle tend alors à se dérouler spontanément dans une direction donnée –, il importe d'en connaître la vitesse. Cela conditionne le passage du laboratoire à l'unité de production industrielle, qui se doit de fonctionner sans à-coups et sans réactions intempestives ; ce passage implique la réalisation d'installations « pilotes » de plus en plus grosses permettant d'optimiser les conditions de la réaction.

LES MÉCANISMES DE RÉACTION

Une réaction chimique s'accompagne de réarrangements dans la position des atomes ainsi que de modifications des diverses liaisons interatomiques. La façon dont ces changements se produisent au cours du temps constitue le mécanisme de réaction (ou mécanisme réactionnel). Celui-ci se déduit d'études sur la cinétique.

Très souvent, une réaction chimique peut être décomposée en réactions plus simples, dites réactions élémentaires. Par exemple, l'oxydation de HI (iodure d'hydrogène) par H2O2 (eau oxygénée) s'effectue en deux étapes :

HI + H2O2 → HOI + H2O (1) et HOI + HI → I2 + H2O (2)

soit, au total : 2HI + H2O2 → I2 + 2H2O.

Dans ce schéma, l'espèce HOI qui est créée dans la réaction (1) mais consommée dans la réaction (2) est un intermédiaire réactionnel. Sa durée de vie peut être très brève, mais elle est, en principe, mesurable. Cet intermédiaire peut être observé par des techniques spectroscopiques.

Si l'on considère maintenant une réaction élémentaire (réaction se déroulant en une seule étape), on peut préciser la synchronisation entre les mouvements des différents atomes. L'exemple le plus simple est celui d'une réaction de substitution au cours de laquelle il se produit un mouvement concerté des atomes. Ceux-ci passent par une configuration géométrique instable, appelée complexe activé, qui n'est réalisée que pendant une durée de l'ordre de la période d'une vibration moléculaire (10−13 s).

L'ÉCRITURE DES RÉACTIONS CHIMIQUES

RÉACTIONS QUANTITATIVES

Depuis l'introduction, en 1815, par le baron Jöns Jacob Berzelius, de la représentation des éléments chimiques par des symboles auxquels sont associées des masses atomiques, on décrit les réactions chimiques par des équations chimiques, où apparaissent les formules des espèces chimiques initiales et finales.

Ces équations apportent toutefois beaucoup plus d'informations que la simple indication qualitative des espèces qui réagissent et de celles qui sont formées à l'issue de la réaction : la connaissance des masses atomiques (qui ont été établies avec une grande précision, à l'exception de celles des éléments radioactifs) permet de déterminer, de façon quantitative, les masses de réactifs qu'il faut mettre en présence pour obtenir les produits de la réaction sans qu'il reste de produits initiaux si celle-ci est complète.

Ainsi, en faisant réagir de l'aluminium (Al) et du soufre (S), on obtient du sulfure d'aluminium (Al2S3), suivant la réaction : 2Al + 3S → Al2S3. Les coefficients placés devant les symboles chimiques (appelés coefficients stœchiométriques) représentent les nombres de moles de chaque réactif qu'il faut mettre en présence pour que la réaction soit complète. Deux moles d'aluminium (de masse molaire M = 27 g), soit 54 g, mélangées à trois moles de soufre (M = 32 g), soit 96 g, donnent ainsi une mole de Al2S3 (M = 2 × 27 + 3 × 32 = 150 g). La réaction est complète tant que la proportion 54/96 est respectée. On exprime, par cet exemple, la loi de la conservation de la masse de Lavoisier, suivant laquelle la masse des substances formées est égale à celle des substances initiales.

Cela signifie, en particulier, qu'une équation chimique doit toujours faire apparaître autant de fois le symbole d'un élément dans sa partie gauche (réactifs initiaux) que dans sa partie droite (substances formées).

Dans le cas où des gaz interviennent, comme dans la réaction d’oxydation complète du fer par le dioxygène : 3 Fe + 2O2 → Fe3O4, il est plus utile d'utiliser le volume molaire (le même pour tous les gaz), qui vaut 22,4 l à 0 °C. Ainsi, 3 moles de fer (M = 56 g), soit 168 g, réagissent avec 2 moles d'oxygène, soit 44,8 l, pour donner une mole d'oxyde de fer (M = 3 × 56 + 4 × 16), soit 232 g de Fe3O4.

RÉACTIONS COMPLÈTES OU LIMITÉES

Les équations chimiques permettent également d'indiquer si les réactions qu'elles représentent sont complètes ou limitées. Lorsque la réaction est complète, elle s'exprime dans l'équation par une flèche orientée de gauche à droite (→) située entre les formules des réactifs initiaux et celles des substances formées.

Lorsqu'une réaction est limitée, elle conduit à un équilibre chimique, et cela s'exprime par deux flèches de sens opposés (⇄) dans l'écriture de l'équation : on indique ainsi que, dans les conditions expérimentales (pression, température) dans lesquelles se produit la réaction, les espèces chimiques mentionnées à gauche réagissent partiellement entre elles pour former les substances mentionnées à droite, mais que, dans les mêmes conditions, les espèces chimiques de droite peuvent réagir partiellement entre elles pour former les espèces de gauche.

Tel est le cas de l'acide acétique et de l'éthanol, qui, lorsqu'on les met en présence, en proportion équimolaire, aussi longtemps qu'on veut à la température ordinaire, ne réagissent qu'en partie en formant de l'acétate d'éthyle et de l'eau :

CH3―COOH + CH3―CH2―OH ⇄ CH3―COO―CH2―CH3 + H2O.

Dans les mêmes conditions, si l'on met en présence de l'acétate d'éthyle et de l'eau en proportion équimolaire, ils se transforment partiellement en acide acétique et en éthanol, et l'état d'équilibre obtenu est identique dans les deux cas.

CATALYSE ET VITESSE DE RÉACTION

Certaines réactions n'ont lieu qu'en présence de substances bien précises, appelées catalyseurs, qui aident les produits à se former, mais n'entrent pas dans la composition des produits en réaction. Au sein d'une cellule, par exemple, les réactions biochimiques sont en général catalysées par des protéines particulières appelées enzymes, et l'on compte pratiquement autant d'enzymes qu'il y a de réactions chimiques. En isolant, en 1833, l'amylase, une enzyme pouvant scinder l'amidon, Anselme Payen et Jean-François Persoz ont démontré toute l'importance de ces catalyseurs (qu'ils appelaient à l'époque des diastases) : ils permettent en effet d'extraire l'énergie contenue dans les longues chaînes carbonées, par exemple les aliments chez l'homme. Ainsi la lipase aide à digérer les graisses en les découpant en éléments plus simples appelés acides gras, la lactase décompose le lactose, ou sucre du lait, en sucres assimilables (glucose et galactose). → catalyse

La vitesse de réaction chimique est un facteur déterminant : elle dépend notamment de la température et de la concentration des réactifs en présence. Une réaction pourra se produire instantanément tandis qu'une autre nécessitera un temps très long. Par exemple, l'oxydation du fer à l'air libre, la rouille, peut durer des jours, voire des années si l'air est sec. En revanche, une explosion de nitroglycérine est la manifestation d'une réaction chimique extrêmement rapide qui libère une grande quantité de gaz en un temps très court : d'où la destruction provoquée par l'onde de choc de l'explosion.

Voir également : électrolyse, oxydoréduction.

BIOCHIMIE

Les phénomènes d'oxydation au niveau des cellules ont une grande importance parmi les phénomènes vitaux. Qu'elles soient attribuées à une fixation directe de l'oxygène (Warburg) par la catalyse des oxydases ou à une déshydratation sous l'influence des déshydrases (Thunberg et Wieland), les oxydations cellulaires sont le résultat d'actions enzymatiques qui aboutissent finalement à la production d'énergie et à l'élimination des déchets toxiques.

DOCUMENT larousse.fr LIEN |

| |

|

| |

|

|

|

La grande oxygénation de l’atmosphère terrestre revisitée |

|

|

| |

|

| |

La grande oxygénation de l’atmosphère terrestre revisitée

vendredi 8 juin 2018

Pour comprendre quand, comment et à quelle vitesse l’oxygène est devenu un composant de notre atmosphère entre environ 2,5 et 2,2 milliards d’années, une équipe internationale

Pour comprendre quand, comment et à quelle vitesse l’oxygène est devenu un composant de notre atmosphère entre environ 2,5 et 2,2 milliards d’années, une équipe internationale(1) a étudié la systématique des quatre isotopes du soufre dans plus de 700 mètres de dépôts sédimentaires australiens. Les résultats obtenus montrent que l’oxygénation de la planète a commencé bien plus tôt que traditionnellement admis et que son enregistrement n’a pas été synchrone d’un continent à l’autre (Australie, Afrique du Sud, Amérique du Nord) mais étalé dans le temps sur presque 300 millions d’années. Ce décalage apparent reflète un effet local lié à l’altération en conditions oxydantes de surfaces continentales plus anciennes.

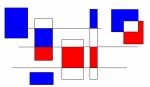

En l’absence d’oxygène dans l’atmosphère, la photolyse UV de dioxyde de soufre (SO2) libéré par l’activité volcanique se traduit par la production de composés soufrés caractérisés par des fractionnements isotopiques très particulier dits indépendant de la masse (noté, MIF-S). En se dissolvant dans l’océan, ces composés soufrés transfèrent cette anomalies isotopiques au registre sédimentaire lors de leur précipitation sous forme de pyrite, par exemple. En présence d’oxygène atmosphérique, ces fractionnements isotopiques particuliers disparaissent. La grande oxygénation de l’atmosphère terrestre (Great Oxidation Event, GOE) entre 2,5 et 2,2 milliards d’années (Ga) a été définie comme l'intervalle de temps pendant lequel une quantité suffisante d'oxygène atmosphérique était présent pour empêcher la production et le transfert de ces anomalies isotopiques dans le registre sédimentaire. La disparition de ces anomalies isotopiques dans des sédiments d’Afrique du Sud sur quelques mètres d’épaisseur de sédiments, a conduit des études précédentes à proposer que l’augmentation de l’oxygène dans l’atmosphère a été rapide (moins de 10 millions d’années, Ma) et globalement synchrone à environ 2,32 Ga sur l’ensemble du globe. Cependant, comme illustré dans la figure, la présence d’importantes lacunes sédimentaires dans les séquences d’Afrique du Sud implique que ce modèle d’oxygénation reste mal contraint.

Corrélation temporelle des séquences sédimentaires associées au GOE d’Australie, d’Amérique du Nord et d’Afrique du Sud. Le modèle d’oxygénation proposé (noté GOE*, Australie) est indiqué comme un intervalle d’environ 300 Ma. L’intervalle noté GOE en Afrique du Sud correspond au modèle classique, dans lequel l’oxygénation de l’atmosphère est considéré comme rapide (1 à 10 Ma) et globalement synchrone à environ 2,32 Ga sur l’ensemble du globe. Les segments rouges et bleus à droite des colonnes stratigraphiques représentent la composition isotopique en soufre des pyrites sédimentaires. MIF = Fractionnement indépendant de la masse. MDF = Fractionnement dépendant de la masse.

Afin de mieux contraindre les mécanismes, l’amplitude et la durée du GOE, nous avons réalisé une campagne de forages dans le bassin du Hamersley en Australie occidentale afin de pouvoir étudier un échantillonnage représentatif qui recoupe la période entre 2,5 et 2,2 Ga associée au GOE. La séquence sédimentaire étudiée est le groupe du Turee Creek, laquelle, à la différence de ses équivalents d’Afrique du Sud et d’Amérique du Nord, ne présente pas de discontinuité sédimentaire majeure.

L’analyse des isotopes du soufre à haute résolution stratigraphique montre un signal MIF-S relativement homogène et de faible amplitude (1± 0.5‰) sur l’ensemble des carottes. Ce signal est ponctué de plusieurs intervalles sédimentaires dans lesquels les sulfures ne présentent pas d’anomalies MIF-S. La présence d’épisodes de dépôt sans MIF-S impliquent que des quantités non négligeables d’oxygène étaient présentes dans l’atmosphère dès 2,45 Ga. Le signal MIF-S de l’ordre de 1‰ représente la moyenne des anomalies isotopiques mesurées dans les sulfures de la période archéenne (4,0 à 2,5 Ga) antérieure au GOE.

L’enregistrement d’une telle anomalie sur plus de 700 mètres de carottes de forage ne peut s’expliquer par un processus atmosphérique, mais résulte vraisemblablement de l’altération en conditions oxydantes de surfaces continentales plus anciennes (archéennes) et le recyclage d’un réservoir de sulfate de composition isotopique homogène de l’ordre de 1‰ dans l’océan. Ce modèle permet d’expliquer que l’enregistrement MIF-S dans les sédiments d'Afrique du Sud, d'Amérique du Nord et d'Australie ne soit pas synchrone car dépendant des surfaces d’altération locales. Ces résultats impliquent que le paradigme actuel de définir le GOE à 2,33-2,32 Ga en se basant sur la dernière occurrence de MIF-S en Afrique du Sud doit être abandonné.

Cette étude a été financée par le Labex UnivEarths de l’Université Sorbonne Paris Cité (ANR-10-LABX-0023 and ANR-11-IDEX-0005-02).

Note(s):

* Les laboratoires et organismes impliqués sont les suivants : Institut de physique du globe de Paris (IPGP / CNRS / Université Paris Diderot) et Géosciences Montpellier (Géosciences Montpellier/OREME, Université de Montpellier / / CNRS / Université Antilles), Research School of Earth Sciences (Australian National University, Australie), Laboratoire géosciences océan (LGO/IUEM, CNRS / UBO / UBS), John de Laeter Centre for Isotope Research (Curtin University, Australie), Biogéosciences (EPHE / Université de Bourgogne Franche-Comté / CNRS) et School of Biological, Earth and Environmental Sciences (University of New South Wales, Australie).

*

Source(s):

Globally asynchronous sulphur isotope signals require re-definition of the Great Oxidation Event, Philippot, P., Ávila, J., Killingsworth, B., Tessalina, S., Baton, F., Caquineau, T., Muller, E., Pecoits, E., Cartigny, P., Lalonde, S., Ireland, T., Thomazo, C., Van Kranendonk, M.J. and Busigny, V., Nature Communications, DOI: 10.1038/s41467-018-04621-x, 8 juin 2018

Contact(s):

* Pascal Philippot, IPGP et Géoscience Montpellier

* pascal [dot] philippot [at] umontpellier [dot] fr, 07 81 11 07 63

DOCUMENT CNRS LIEN

|

| |

|

| |

|

| Page : [ 1 2 3 4 5 6 7 8 9 10 ] - Suivante |

|

|

|

|

|

|